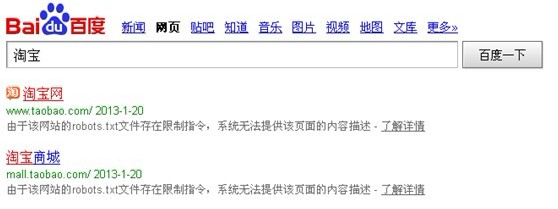

摘要:为了能够让站长更方便的了解网站页面在出现上述问题时是否是由于设置了robots文件,百度网页搜索结果中上线了robots.txt文件提示。

作为网站管理员,在某些时候我们或许注意到百度搜索结果页面缺失了网页摘要或重要信息。这通常是由于robots.txt规则配置错误所致。对此,我们可以通过使用百度最近推出的搜索首页机器人协议文件提示功能来迅速有效地解决这个问题。

robots.txt文件的作用

针对搜索引擎在首度访问网站时需读取的关键文件——Robots.txt,其主要职能是规定搜索引擎爬虫的检索范围。通过设立此文件,网站管理人员能清晰划分出哪些页面适于被索引,而哪些应予剔除,从而做到灵活调控搜索引擎对站点内容的索引程度,实现对用户隐私和特殊信息的合理保护以及防止其无节制传播。

robots.txt的设置与百度搜索

为保护个人隐私及相关因素,某些网站采用robots.txt文件规范搜索引擎如百度等的访问权限。搜索引擎将依据此类规则,尊重且避免抓取受限区域数据。尽管如此,搜索结果中仍显示网站标题及网址,而摘要内容则被隐藏。

robots.txt文件的提示作用

为协助站长迅速发现并解决在搜索引擎结果中缺失摘要展示的问题,百度已于搜索结果页悄然增加了robots.txt文件警示功能。如有页面或整体情况受此文件管控时,搜索结果将给予提示,助站长大幅提升修正错误设置的效率。单击"详情"链接,即可获取详尽的Robots.txt数据,由此确定是否因设置不妥而使页面受限。

百度站长平台的robots工具

百度站长平台推出机器人工具,为站长精编与查验robots.txt文档提供便利。本工具可精准生成robots.txt文件,并实时监测网站未受欢迎的搜索引擎抓取内容。借助于此工具精确设定robots.txt文件,站长得以有效主导网站在搜索引擎内的收录,从而提升用户体验及站点安全性。

robots.txt文件的使用建议

对于机器人抓取策略(robots.txt)的运用,网站负责人须视实际需求定制。若全网内容皆期望被搜索引擎抓取,则无需制定该文档。反之,欲屏蔽部分不愿被采集的数据,则需要精心构建robots.txt来阻止无关信息。此外,责任人还应对其进行定期审查,确保其与网站运营准则及政策保持一致。

robots.txt文件的优化与注意事项

为充分发挥robots.txt文件的潜力,管理员需遵循以下优化准则:首先,务必保证文件语法正确,以免因格式错误引发问题;其次禁止百度收录robots代码,加注说明有助于明确文件运行机制及参数设置;最后,对于关键保密数据,宜实施双重防护措施,不过分依赖robots.txt文件。

robots.txt文件的适用范围

不论是普通博客还是高级电商,Robots.txt都能很好地约束搜索引擎的索引行为。必须指出,虽然Robots.txt有助于防范恶意爬虫,然而对敏感数据的防护还需结合多种技术手段。

robots.txt文件的合规性与搜索引擎政策

在编写robots.txt文件时,务必遵守搜索引擎策略,保证合规性,防止意外设置影响网站的排名和信誉。因此,站长需严格按照行业标准进行设计和编写。

robots.txt文件的未来发展趋势

鉴于当前网络科技迅猛发展,搜索引擎采用程序猿规则(Robots.txt)上产生了重大变化。未来几年内,依托于人工智能与运算能力的持续提高,搜索引擎将能更准确地掌握并运用这类命令,从而更好地满足站长和使用者的期望值。同时禁止百度收录robots代码,在重视隐私权保护和数据安全性加强的背景下,机器人使用协议在网站运营中的地位必将凸显,成为必要工具之一。

关于robots.txt,请问您有哪些独特的见解和实践经验?在网站日常维护过程中,是否曾遇到过相关挑战?请不吝赐教,让我们共同学习探讨。